Bots: technische Grundlagen

Dr. Raphael Wimmer

Seminar “Mensch und Bot”, Sommersemester 2025

Ziele

- Überblick über das Themenfeld

- Klären unbekannter Begriffe

- Intuition: Funktionsweise, Unterschiede, Grenzen

Überblick

- klassische Chatbots: Heuristiken, Grammatiken, Markup-Sprachen

- Large Language Models: Generative Pre-Trained Transformers

Klassische Chatbots

Eliza

Reagiert auf bestimmte Schlüsselwörter:

(REMEMBER 5

((0 YOU REMEMBER O)

(DO YOU OFTEN THINK OF 4)

(DOES THINKING OF ~ BRING ANYTHING ELSE TO MIND)

(WHAT ELSE DO YOU REMEMBER) )

((0 DO I REMEMBER 0)

(DID YOU THINK I WOULD FORGET 5)

(WHY DO YOU THINK I SHOULD RECALL 5 NOW)

(YOU MENTIONED 5) )

adaptiert von Weizenbaum, J. (1966) ELIZA A Computer Program For the Study of Natural Language Communication Between Man And Machine

AI Markup Language (AIML)

<aiml version="1.0.1" encoding="UTF-8">

<!-- basic_chat.aiml -->

<category>

<pattern>HELLO</pattern>

<template>

Well, hello!

</template>

</category>

<category>

<pattern>WHAT ARE YOU</pattern>

<template>

I'm a bot, silly!

</template>

</category>

</aiml>

Relevante Konzepte

Gemeinsame Reflektion: was genau ist das?

- Neuronale Netzwerke

- Embeddings

- Transformers

- Generative Pre-trained Transformers

- Finetuning

- Reinforcement Learning with Human Feedback (RLHF)

Embeddings

Transformers

- https://en.wikipedia.org/wiki/Attention_(machine_learning)

Aufgabe: LLMs vergleichen

- Exploriert zu zweit, wie gut die verschiedenen LLMs dort sind

- Beispiel-Prompts:

- Erzähle einen Witz mit Bezug zur Uni.

- Gib mir drei Beispiele für besonders ausgefallene Vornamen, die trotzdem nicht peinlich sind. Keine weiteren Erklärungen oder Kommentare bitte, nur die Namen.

- Wieviele Ameisen passen in eine Hosentasche?

Prompts

- System Prompt: gibt Kontext vor, für Nutzer nicht zwingend sichtbar (Überblick System-Prompts)

- User Prompt: was der Benutzer eingibt

- Jailbreaks: System-Prompt-Vorgaben und weitere Sicherheitsmaßnahmen umgehen (nettes Spiel)

Temperature parameter

Nimm nicht immer das wahrscheinlichste nächste Wort, sondern auch mal ein unwahrscheinlicheres

Prompt: "Es war einmal ein"

Temp = 0.0:

"Es war einmal ein kleiner Fuchs, der tief im grünen Wald lebte. Jeden Morgen, wenn die Sonne durch die Blätter schien, sprang er fröhlich aus seinem Bau und begrüßte den Tag mit einem fröhlichen Lied.

Temp = 1.85:

"„Es war einmal…“ – Dieser klassische Satz beginnt viele interessante Märchen und Geschichten! Möchtest du, dass ich ein Märchen mit „Es war einmal…“ erfinden und erzählen soll? Schön, dann lass etwas Magie entstehen! Nachfolgend geht es nach einer **typischen Märcheneröffnung freierfindנ вести Einzahlungపై worੁছে疯间坊变gy [...]"

Temp = 2.0:

"nachtens ein woo Mongoanal Responsibilityinenvi squeez leisurelydak Dord authenticity ras synthesis Unternehmen contingent Lam dominant military Rad raisins.Flag пак Lewis schwierعامEEEE intrigued wneudară‰italic [...]"

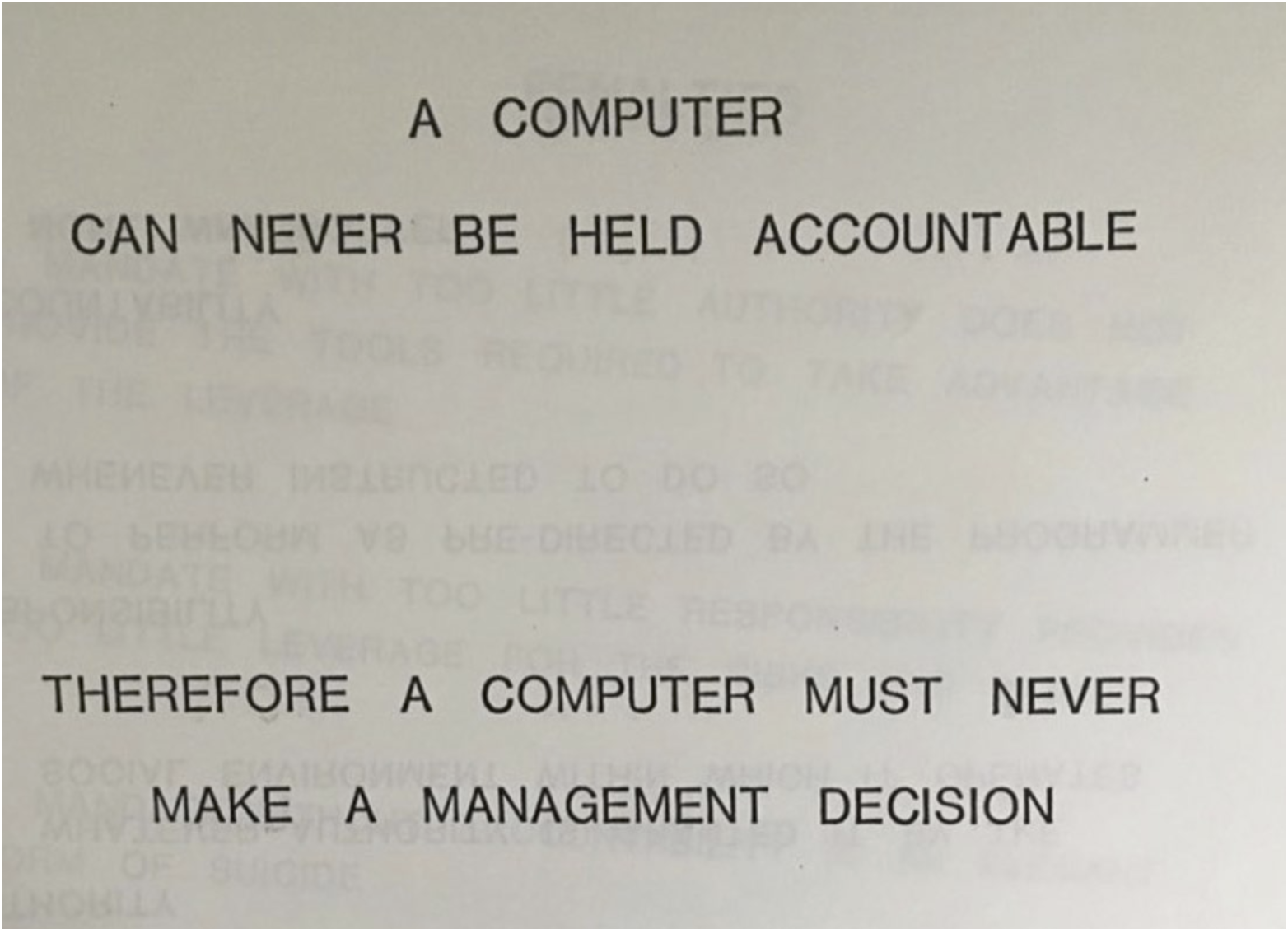

RLHF

Neue ChatGPT-Version schleimt rum, wird auf Vorversion zurückgesetzt.

"[...] when users had given the chatbot a thumbs-up, they used this data to make the chatbot behave more in that direction, and it was penalized for thumb-down. And it happens to be that some people really like flattery. In small doses, that’s fine enough. But in aggregate this produced an initial chatbot that was really inclined to blow smoke."

https://www.fastcompany.com/91335473/steven-adler-interview-chatgpt-sycophancy-grok-south-africa

siehe auch: OpenAI Used Kenyan Workers on Less Than $2 Per Hour to Make ChatGPT Less Toxic